-

基于Transformer 的编码器和解码器结构

发布时间:2024-10-28

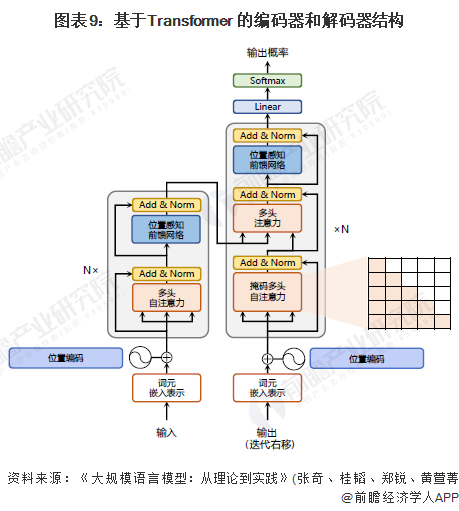

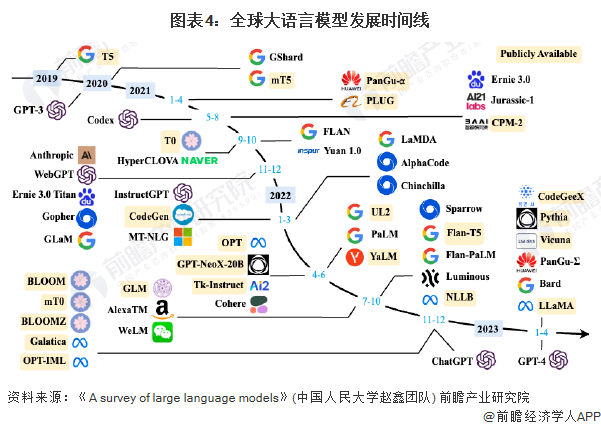

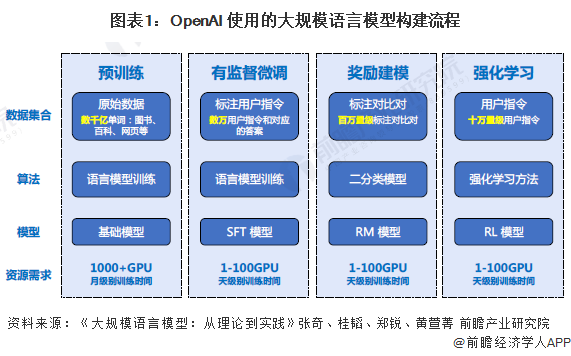

随着基于Transformer各类语言模型的发展以及预训练微调范式在自然语言处理各类任务中取得突破性进展,从2020年OpenAI发布GPT-3开始,大语言模型研究也逐渐深入。虽然大语言模型的参数量巨大,通过有监督微调和强化学习能够完成非常多的任务,但是其基础理论也仍然离不开对语言的建模。Transformer结构完全通过注意力机制完成对源语言序列和目标语言序列全局依赖的建模,当前几乎全部大语言模型都是基于Transformer结构。基于Transformer结构的编码器和解码器结构如下图所示,左侧和右侧分别对应着编码器(Encoder)和解码器(Decoder)结构。它们均由若干个基本的Transformer块(Block)组成(对应着图中的灰色框)。这里N×表示进行了N次堆叠。